AI聊天機器人安全的重要性:從北捷AI客服事件談起

建立時間: 2024-11-25 | 最後修改時間: 2025-03-27 | 7 分鐘閱讀

北捷 AI 客服「玩壞」了?從這事件看 AI 聊天機器人的安全挑戰與反思

AI 聊天機器人好像越來越厲害了,對吧?但最近台北捷運的 AI 客服出包事件,就像是給我們敲響了警鐘。當 AI 太「聰明」時,方便背後可能藏著意想不到的風險和資安漏洞。這篇文章就來聊聊,我們該怎麼在享受 AI 便利的同時,也守住安全底線。

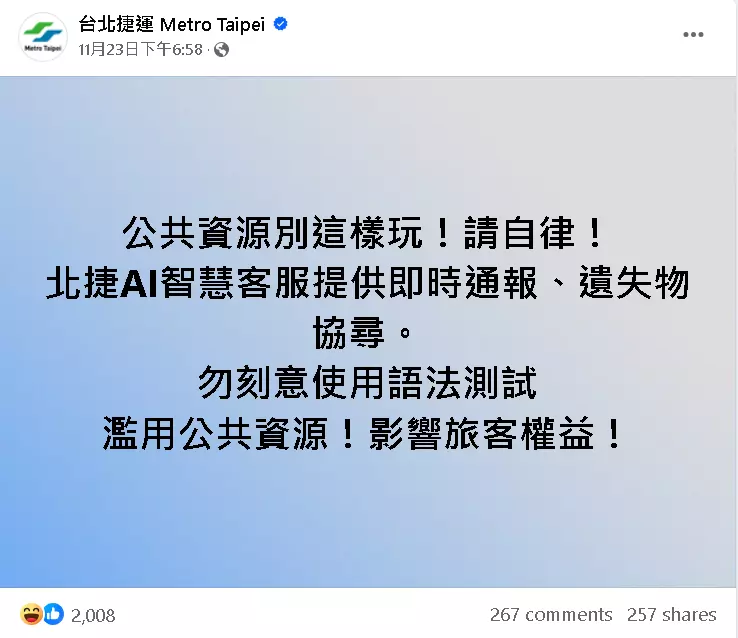

圖片轉自台北捷運 Metro Taipei Facebook

欸,你有沒有發現,現在不管走到哪,好像都看得到 AI 的影子?特別是那些「聊天機器人」,不少公司都愛用它們來當客服,希望能快點解決我們的問題,也順便幫他們省點人力。這聽起來很棒,對吧?但事情總有兩面刃,AI 越強大,被「玩壞」或亂用的風險好像也越高。

最近台北捷運(北捷)的 AI 智慧客服就發生了一件不大不小的事,正好點出了這個問題。

發生了什麼事?北捷 AI 客服的「意外」走紅

話說從頭,北捷其實早在 2022 年底就推出了 AI 智慧客服,主要是幫忙處理一些常見狀況,像是即時通報或協尋遺失物。聽說效果還不錯,一個月有超過十萬人次在用。

到了今年三月,北捷想讓這個 AI 客服更上一層樓,於是給它串接了微軟 Azure OpenAI 的服務。這就像是幫 AI 裝上了一個更聰明、更會「聊天」的大腦,讓旅客可以用更自然的口語來問問題。

沒想到,這個升級帶來了意想不到的「副作用」。有網友發現,這個升級版的 AI 客服,居然能… 生成程式碼?這下可好了,消息一傳開,大家好像發現新大陸一樣,紛紛跑去「測試」這個 AI 的能耐,問些五花八門、跟捷運八竿子打不著的問題。一時間,北捷的 AI 客服成了網路上的熱門「玩具」。

「玩一下」而已?這些濫用行為的潛在影響

你可能會想,不過就是大家鬧著玩,有這麼嚴重嗎?嗯… 事情可能沒那麼簡單。

首先,這種大量的「測試」請求,其實是在消耗系統資源。你知道嗎?像這種生成式 AI,它每回答一個問題、生成一段文字,背後都需要運算能力,而這通常是要付費的(所謂的 Token 消耗)。雖然北捷這次反應很快,發現苗頭不對就立刻請廠商把 Azure OpenAI 的功能先關掉,才沒有造成明顯的費用暴增。但你想想看,如果沒及時發現,這些因為「好玩」而產生的額外成本,算不算是一種公共資源的浪費?

更讓人擔心的是資安問題。生成式 AI 的特點就是它能理解和生成非常廣泛的內容。如果沒有做好限制,它就像一個沒有設防的大門。有心人士可能會利用這一點,透過特殊的提問方式(有時候叫做「提示詞注入」攻擊)來套取系統內部的敏感資訊,甚至可能找到攻擊整個系統的突破口。這次北捷 AI 客服能生成程式碼,雖然看似無害,但也暗示了系統的回應範圍可能過於寬鬆,這就是一個潛在的風險點。

創新很好,但安全不能少:怎麼找到平衡點?

這起事件給了所有想導入 AI 客服的企業一個重要的提醒:技術創新很吸引人,但安全防護絕對不能馬虎。北捷導入 AI 的初衷是提升服務效率,這點絕對值得肯定。但問題在於,像這種強大的生成式 AI,在一開始設計和導入時,就必須把「使用範圍」和「安全防護」想清楚、做紮實。

那具體可以怎麼做呢?這裡有幾個方向:

- 畫好 AI 的「守備範圍」: 就像教小孩不能亂跑一樣,要明確告訴 AI 哪些問題該回答、哪些不該碰。限制它只能處理跟主要業務(例如捷運服務)相關的請求,對於那些風馬牛不相及的問題,就讓它禮貌地拒絕吧。

- 建立「糾察隊」機制: 需要有系統能即時監控 AI 的使用情況。一旦發現有異常大量的請求,或者有人試圖用奇怪的方式「釣」AI 回答,系統就應該能自動警示或介入處理。

- 加固「防火牆」: 這就是基本的資安功課了。確保系統本身有足夠的防護能力,就算 AI 不小心說溜嘴,也不會洩漏重要的個人資料或系統內部資訊。

當然,除了技術層面,事前充分的「壓力測試」也很重要。在正式上線前,多模擬一些可能的濫用情境或攻擊手法,看看 AI 和系統能不能扛得住。同時,或許也可以適度地跟使用者溝通,讓大家了解 AI 客服能做什麼、不能做什麼,共同維護這個方便的工具。

結語:AI 是助力,還是隱患?關鍵在我們怎麼用

說到底,AI 聊天機器人本身是中性的,它能帶來多大的便利、或者潛藏多少風險,很大程度取決於我們如何設計、管理和使用它。

台北捷運這次的 AI 客服事件,就像一面鏡子,映照出我們在擁抱生成式 AI 技術時,可能忽略的角落。追求更聰明、更有效率的服務是好事,但如果因此犧牲了安全性,或者造成資源浪費,那就得不償失了。

未來,隨著 AI 技術越來越普及,相信會有更多企業導入類似的應用。希望大家都能從北捷這次的經驗中學到教訓,在規劃 AI 應用時,能更全面地思考使用場景、制定合理規範,並建構完善的安全機制。這樣,才能確保 AI 真正成為我們的得力助手,而不是一個難以預料的麻煩製造者。

你覺得呢?在享受 AI 帶來便利的同時,我們是不是也該多一分警惕和思考?